Negli ultimi anni il termine “deepfake” è diventato sempre più presente nella nostra vita. Si tratta di una tecnologia, basata sull’AI, che ha suscitato tanto interesse quanta preoccupazione per il suo potenziale utilizzo nella diffusione di notizie false e manipolazione di dati e dell’opinione pubblica.

Ma come è nato il deepfake? Quali sono le prospettive di utilizzo? Come possiamo distinguere un contenuto manipolato? Per avere la risposta a ogni domanda, leggi l’articolo completo!

Definizioni e origini del deepfake

Il termine “deepfake” è una combinazione di “deep learning” e “fake”. Un deepfake è una forma di manipolazione multimediale avanzata basata sull’intelligenza artificiale, in particolare, riguardo a tecniche di apprendimento profondo e generazione di reti neurali artificiali. In parole semplici, si tratta di una tecnologia che consente di creare contenuti in modo da far sembrare che un elemento falso risulti reale.

Il deepfake è divenuto particolarmente noto a partire dal 2017, quando le sue applicazioni pratiche hanno cominciato a emergere e diffondersi in modo significativo. Uno dei suoi primi utilizzi è avvenuto nel campo dell’intrattenimento, in particolare riguardo alla manipolazione di video a fini comici o parodici.

Il caso Reddit

Nel dicembre del 2017, un utente del sito di social news statunitense Reddit, il cui nickname era Deepfakes, iniziò a postare clip di film, sostituendo i volti degli attori con altri, suscitando curiosità e divertimento nella community. Ben presto questi contenuti diventarono virali e si iniziò a realizzarne altri, ma di natura diversa, ovvero diffamatori.

Al di fuori di Reddit, che ebbe al tempo notevoli problematiche legali da affrontare, i deepfake si diffusero esponenzialmente, spesso accompagnati dalla condivisione di link ad applicazioni utili per la loro creazione.

La creazione di un deepfake: tecniche e strumenti

La creazione di un deepfake richiede l’utilizzo di tecniche e strumenti sofisticati, nonché grande conoscenza informatica ed esperienza avanzata.

Uno dei metodi più comuni per realizzarli consiste nell’utilizzare algoritmi di deep learning, basati su intelligenza artificiale, che permettono alle macchine di apprendere schemi complessi provenienti dai dati.

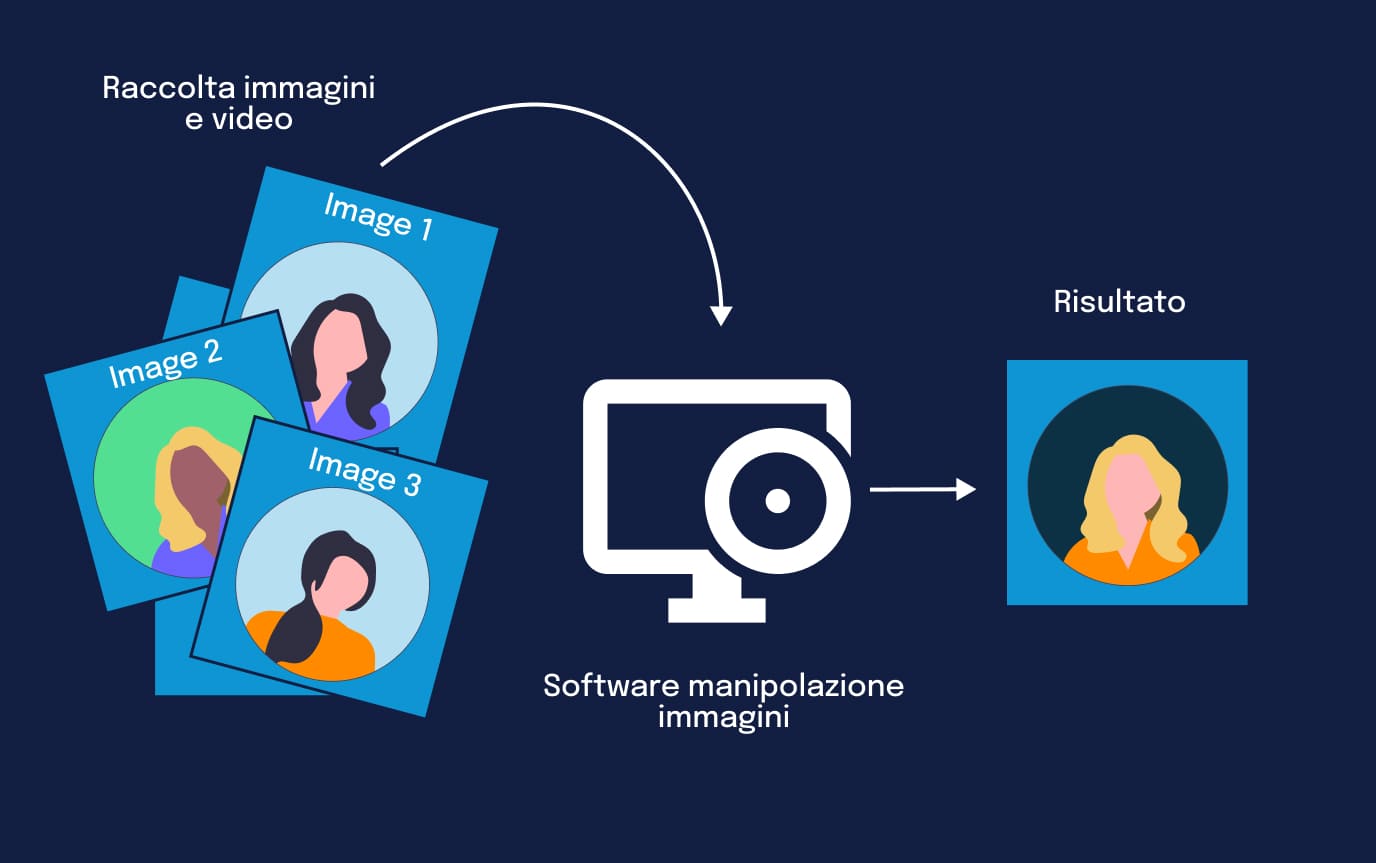

Il processo di realizzazione di un deepfake richiede la raccolta di molte immagini o video del contenuto che si vuole falsificare, oltre all’utilizzo di software specializzati per la manipolazione delle immagini. Spesso vengono utilizzati Generative Adversarial Network (GAN), ovvero reti che consentono di creare immagini fotorealistiche a partire da pochi input. Queste possono essere addestrate su immagini e video esistenti, per poi generare nuovi visual che appaiono autentici, ma che in realtà sono falsi.

In aggiunta, vengono sfruttati software di editing video avanzati, che permettono di modificare espressioni facciali, mimica e movenze del soggetto, fino a ottenere una riproduzione estremamente fedele all’originale.

Oggi, con lo sviluppo delle tecnologie e la diffusione massiva delle informazioni, la realizzazione di tali contenuti sta diventando sempre più semplice. Di conseguenza, nascono numerose preoccupazioni tra utenti privati e aziende su ciò che potrebbe accadere nel futuro prossimo.

Prospettive future sugli utilizzi dei deepfake

Nei prossimi anni non sarà difficile trovarsi di fronte a una crescita degli episodi di diffamazione, inganni e furti di identità a causa di deepfake estremamente accurati e realistici. Questi attacchi, sempre più sofisticati, potrebbero estendersi e arrivare addirittura alla manipolazione dei mercati o alla propaganda politica. Le vittime, sia individui sia organizzazioni, potrebbero essere esposte a danni reputazionali, sfide alla sicurezza e all’integrità delle informazioni, proprio a causa della difficoltà nel distinguere realtà e finzione.

Il 2024 viene considerato, da alcuni esperti del settore, l’anno dei deepfake. La facilità d’uso degli strumenti necessari per crearli è in aumento, soprattutto grazie all’efficacia dell’intelligenza artificiale generativa. Le innovazioni previste per quest’anno riguardano in particolare il settore AV. Il settore video si sta evolvendo e, grazie alla combinazione di voci clonate e video, è possibile generare filmati estremamente convincenti. Il settore delle tecnologie di clonazione vocale ha raggiunto una precisione notevole in grado di minacciare la sicurezza delle misure basate sulla voce e delle segreterie telefoniche.

Il 2024 viene considerato, da alcuni esperti del settore, l’anno dei deepfake. La facilità d’uso degli strumenti necessari per crearli è in aumento, soprattutto grazie all’efficacia dell’intelligenza artificiale generativa. Le innovazioni previste per quest’anno riguardano in particolare il settore AV. Il settore video si sta evolvendo e, grazie alla combinazione di voci clonate e video, è possibile generare filmati estremamente convincenti. Il settore delle tecnologie di clonazione vocale ha raggiunto una precisione notevole in grado di minacciare la sicurezza delle misure basate sulla voce e delle segreterie telefoniche.

La necessità di discernere l’autenticità di contenuti audiovisivi potrebbe portare all’evoluzione di un’industria specializzata nello sviluppo di strumenti d’IA per il rilevamento di contenuti creati da altre tecnologie simili.

Come distinguere e rilevare i deepfake

I primi deepfake contenevano alcuni “bug” tecnici che rivelavano facilmente un fake. Poiché la manipolazione di contenuti avanzati riguarda spesso trasformazioni facciali, le analisi si concentravano sui volti, verificando “anomalie”, come il battito delle ciglia estremamente rallentato e alcune diversità innaturali nel viso.

Oggi, l’accuratezza dei contenuti deepfake rende complesso il meccanismo di riconoscimento di ciò che è reale ed è per questo che il Garante della privacy, nel proprio vademecum di fine 2020, suggerisce agli utenti di avere particolare attenzione nell’approccio con un potenziale deepfake. Un ulteriore contributo, dato già nel 2019, è stato quello di Google che, tramite un proprio database costituito da oltre 3.000 deepfake tra dati, immagini e video, si proponeva di aiutare gli sviluppatori nel creare software utili per riconoscere e rilevare i deepfake.

Dal punto di vista tecnico, oggi esistono sistemi altrettanto avanzati per fronteggiare le minacce dei deepfake, anche se lo sviluppo di questi ultimi viaggia a velocità impressionanti. Si tratta di tecnologie anch’esse basate su intelligenza artificiale che, tramite un addestramento avanzato di reti neurali, sono in grado di rilevare contenuti deepfake e di prevenire eventuali attacchi informatici o episodi spiacevoli.

Abbiamo parlato di questo tema con l’azienda Truescreen, la prima soluzione di cybersecurity che garantisce informazioni autentiche e immutabili su documenti, contratti e report tecnici. Non ti resta che seguire l’ultimo episodio del podcast Nessun Segnale by DotEnv, dove il CEO Fabio Ugolini fa una panoramica sul mondo deepfake e fornisce preziose informazioni su come potersi difendere da contenuti manipolati.

Abbiamo parlato di questo tema con l’azienda Truescreen, la prima soluzione di cybersecurity che garantisce informazioni autentiche e immutabili su documenti, contratti e report tecnici. Non ti resta che seguire l’ultimo episodio del podcast Nessun Segnale by DotEnv, dove il CEO Fabio Ugolini fa una panoramica sul mondo deepfake e fornisce preziose informazioni su come potersi difendere da contenuti manipolati.