L’AI Act rappresenta una svolta significativa nella regolamentazione dell’intelligenza artificiale all’interno dell’Unione Europea. Con l’aumento dell’adozione delle nuove tecnologie, risulta fondamentale assicurare un loro utilizzo sicuro ed etico. Una componente cruciale dell’AI Act è la classificazione dei rischi associati alle applicazioni dell’IA. Vediamola insieme in questo articolo.

Cos’è l’AI Act e quali sono i suoi obiettivi

L’AI Act, o EU AI Act, è una legge che regolamenta lo sviluppo e l’uso delle tecnologie di intelligenza artificiale nell’Unione Europea. L’obiettivo principale dell’AI Act è creare un quadro normativo che garantisca la sicurezza, la trasparenza e l’affidabilità dei sistemi AI, proteggendo al contempo i diritti fondamentali dei cittadini europei. Allo stesso tempo, si prefigge di sostenere l’innovazione, creare un mercato unico dei sistemi di intelligenza artificiale aumentando la fiducia negli stessi, oltre che vietare l’uso di tecnologie che rappresentino pericoli per le persone.

La classificazione dei rischi nell’AI Act

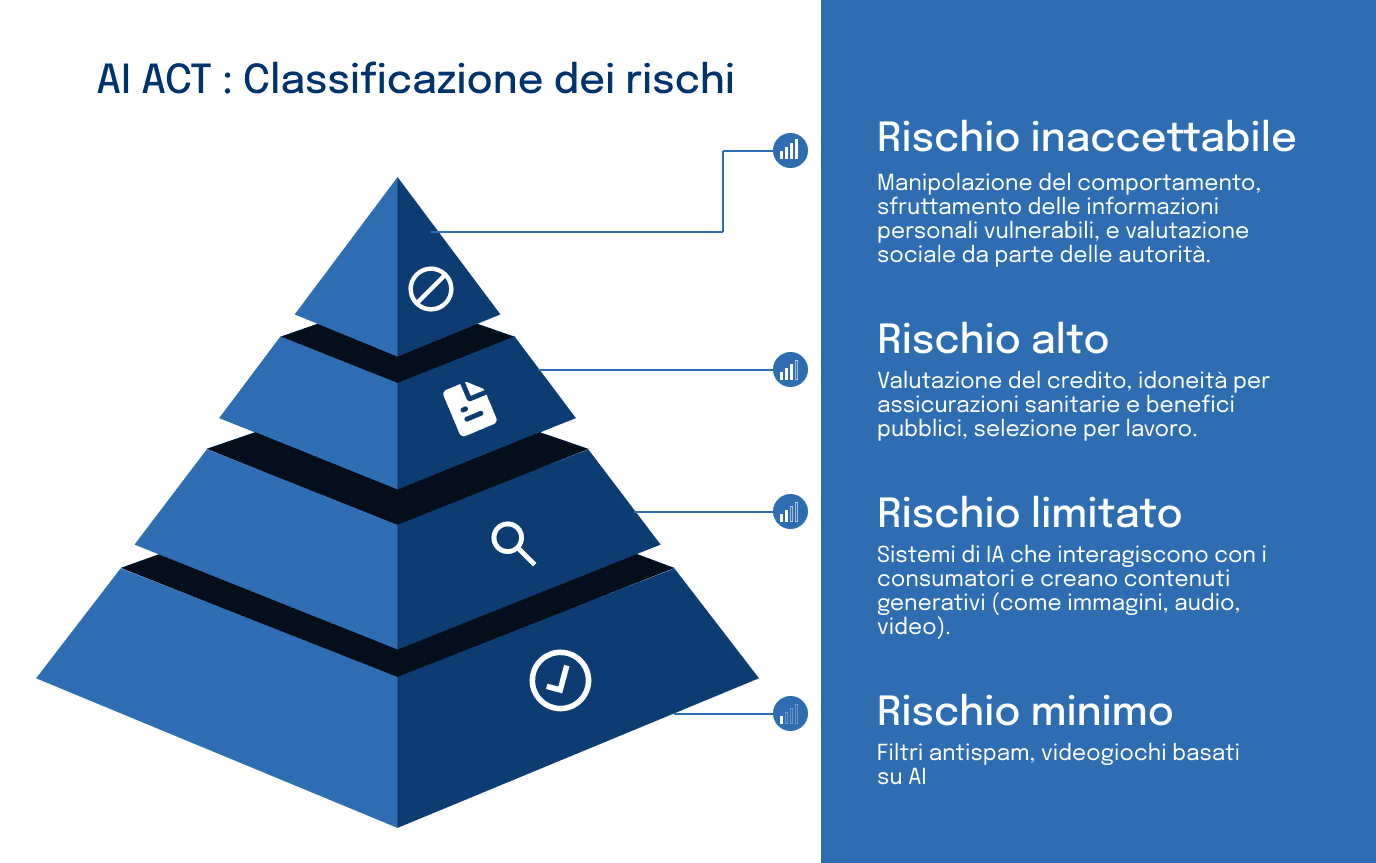

L’AI Act introduce un sistema di classificazione dei rischi per i sitemi di intelligenza artificiale che si dimostra tanto flessibile quanto rigoroso. Questa graduazione, che va dai rischi inaccettabili a quelli minimi, permette di adattare la regolamentazione alle diverse tipologie di sistemi di IA. È fondamentale sottolineare che, sebbene alcuni di essi presentino rischi significativi e siano soggetti a divieti o restrizioni severe, la maggior parte dei sistemi opererà in un contesto di rischio limitato. Questo approccio bilanciato garantisce sia la protezione dei cittadini dai potenziali danni dell’IA, sia la promozione di un ecosistema innovativo e dinamico.

Le principali categorie di rischio definite nell’AI Act sono:

-

Rischio inaccettabile

-

Rischio alto

-

Rischio limitato

-

Rischio minimo

Vediamole assieme nel dettaglio.

Rischio inaccettabile

I sistemi classificati come a rischio inaccettabile sono vietati dalla legislazione. Questi includono applicazioni che violano i diritti fondamentali o che possono causare danni significativi come i sistemi progettati per manipolare il comportamento umano in modo subliminale, compromettendo la libertà di scelta o quelli che valutano il comportamento sociale delle persone su larga scala e che possono portare a discriminazioni.

La restrizione prevista per questa categoria di rischio è la proibizione totale, in quanto questi sistemi contravvengono i diritti fondamentali previsti dall’Unione Europea.

Rischio elevato

I sistemi a rischio elevato sono quelli che possono avere un impatto significativo sulla vita delle persone e che quindi devono soddisfare severi requisiti prima di poter essere utilizzati, come ad esempio, sistemi per la selezione del personale, per l’istruzione, per l’erogazione di servizi sanitari, per le applicazioni di polizia, o per la gestione della sicurezza delle infrastrutture (rete elettrica o i trasporti pubblici).

La restrizione prevista per questa categoria di rischio è quella di essere soggetta a una valutazione di conformità, in quanto risultano a rischio la salute e la sicurezza dei cittadini.

Rischio limitato

I sistemi di IA a rischio limitato richiedono una trasparenza minima e devono informare gli utenti che stanno interagendo con un sistema di intelligenza artificiale. Un esempio classico è rappresentato dai chatbot e dagli assistenti virtuali che interagiscono con gli utenti in modo automatico.

La restrizione prevista in questo caso, è quella di essere soggetti a un obbligo di trasparenza, in quanto i sistemi in questione potrebbero comportare personificazione e inganno.

Rischio Minimo

I sistemi AI a rischio minimo sono considerati sicuri e sono soggetti a una regolamentazione minima. Questi includono filtri antispam e applicazioni di intelligenza artificiale utilizzate nei giochi per migliorare l’esperienza utente.

Non ci sono obblighi previsti per questi sistemi poichè non presentano alcun rischio elevato.

Le implicazioni per gli sviluppatori

L’AI Act impone alle aziende e agli sviluppatori di eseguire valutazioni dettagliate del rischio e di garantire che i sistemi di IA rispettino le norme applicabili, sulla base della classificazione analizzata in precedenza.

Per i sistemi di IA ad alto rischio devono essere soddisfatti requisiti come:

- la qualità dei dati

- la documentazione tecnica

- l’informazione agli utenti

- la sicurezza

- la precisione

- la supervisione umana.

Inoltre, sviluppatori e utilizzatori dovranno procedere con analisi approfondite dei potenziali rischi associati all’uso dei sistemi in oggetto, la cui conformità sarà poi verificata da organismi indipendenti, e dovranno garantirne la registrazione e la tracciabilità.

Per i sistemi di IA a rischio limitato, gli sviluppatori dovranno fornire informazioni chiare e accessibili in merito a caratteristiche e limitazioni di tali sistemi, per poter consentire agli utenti di scegliere se utilizzarli o meno e le implicazioni che ne conseguono.

Infine, per i sistemi a di IA a rischio minimo o nullo non vi sono obblighi specifici, tuttavia è necessario comunque rispettare le leggi generali applicabili all’intelligenza artificiale, in relazione, ad esempio, alla protezione dei dati personali o alla responsabilità civile.

L’AI Act rappresenta un passo significativo verso un utilizzo più sicuro e trasparente delle tecnologie di intelligenza artificiale e la classificazione dei rischi rappresenta senza dubbio un elemento chiave di questa normativa per permettere alle aziende e agli sviluppatori di adottare le misure necessarie per garantire la conformità dei sistemi di IA.

Abbiamo affrontato il tema dell’AI Act con uno dei padri fondatori del regolamento, l’onorevole Brando Benifei, membro del Parlamento Europeo, nell’ultimo episodio del podcast Nessun Segnale by DotEnv.

Se non l’hai ancora ascoltato, o visto, corri a farlo scegliendo la piattaforma che preferisci tra:

YouTube

Spotify

Apple Podcasts

YouTube Music

Amazon Music.

Buona visione e buon ascolto!